Ce ai face dacă medicul tău ți-ar oferi un plan de tratament generat de AI, fără a-ți explica de ce? Ai avea încredere în el?

În peisajul actual al asistenței medicale bazate pe date, AI este în creștere în diagnosticarea bolilor și ghidarea tratamentului personalizat. Dar fără transparență, chiar și cele mai precise AI pot genera îndoială.

AI explicabilă (XAI) oferă perspective clare și ușor de înțeles de către oameni despre cum sunt luate deciziile. Transformă AI dintr-o cutie neagră într-un instrument în care clinicienii și pacienții pot avea încredere.

Să explorăm cum reconfigurează XAI medicina personalizată, de ce contează și care sunt provocările sale.

Înțelegerea AI explicabile (XAI)

AI explicabilă (XAI) se referă la sisteme de inteligență artificială concepute pentru a face procesele lor de luare a deciziilor transparente și ușor de înțeles pentru oameni. În contrast cu modelele tradiționale „cutie neagră” care oferă rezultate fără a-și dezvălui logica, XAI clarifică modul în care intrările influențează rezultatele.

Această claritate este esențială în domeniul sănătății. Când un sistem AI sugerează un diagnostic sau un tratament, medicii și pacienții trebuie să înțeleagă de ce. Instrumente precum SHAP (Shapley Additive Explanations), LIME (Local Interpretable Model-agnostic Explanations) și Grad-CAM sunt utile în acest sens.

Aceste metode dezvăluie care trăsături, puncte de date sau regiuni de imagine au contribuit la decizia AI, făcând procesul interpretabil pentru uz clinic.

Oferind explicații în forme vizuale, textuale sau numerice, XAI transformă ieșirile complexe AI în perspective acționabile. Această transparență ajută la alinierea instrumentelor AI cu raționamentul medical și intuiția umană, ambele esențiale în îngrijirea pacienților.

De ce domeniul sănătății cere explicații

Explicabilitatea joacă un rol critic în construirea încrederii. Cercetările arată că modelele AI opace reduc aderența la tratament și slăbesc colaborarea pacient-medic. Când sistemele AI nu au rațiuni pentru rezultatele lor, clinicienii se luptă să valideze sau să apere recomandările pacienților.

Tratamentul personalizat necesită adaptarea îngrijirii la istoricul fiecărui individ, biologie și preferințe. Fără a înțelege modul în care un sistem AI evaluează acești factori, personalizarea devine lipsită de sens.

Explicabilitatea ajută la îndeplinirea standardelor legale și etice, cum ar fi GDPR-ul UE, care subliniază drepturile indivizilor de a înțelege deciziile automate. Pentru furnizorii de asistență medicală, aceasta înseamnă selectarea instrumentelor AI care își explică raționamentul.

În rezumat, domeniul sănătății cere AI explicabile pentru că:

- Siguranța pacientului necesită claritate, nu presupuneri.

- Încrederea clinică se bazează pe înțelegere, nu pe automatizare.

- Standardele legale cer transparență și responsabilitate.

De ce tratamentul personalizat are nevoie de XAI

XAI dă context pentru deciziile AI. AI explicabilă asigură că personalizarea nu are loc doar în tăcere în fundal—se întâmplă deschis, cu claritate și scop.

Când un sistem recomandă un medicament specific de chimioterapie în locul altuia sau ajustează doza de insulină pentru un pacient diabetic, instrumentele XAI pot arăta care factori au dus la acea alegere.

Aceste explicații ajută medicii să înțeleagă și să comunice recomandarea mai clar pacientului. Pacienții trebuie să înțeleagă compromisurile tratamentelor pe termen lung în îngrijirea cronică și oncologie.

Încredere, aderență și decizii împărtășite

Încrederea este fundamentul medicinei personalizate. Pacienții care nu înțeleg de ce un tratament este ales special pentru ei sunt mai predispuși să îl pună la îndoială sau să îl evite complet. Aici intervine XAI.

Studiile arată că atunci când pacienții primesc justificări transparente și ușor de înțeles pentru deciziile medicale, în special cele generate de AI, sunt mai predispuși să adere la acele tratamente.

În contrast, recomandările vagi sau opace duc la îndoială, reducerea conformității și chiar abandonarea tratamentului.

XAI îmbunătățește luarea deciziilor împărtășite prin permiterea clinicienilor și pacienților să înțeleagă raționamentul din spatele recomandărilor AI. Favorizează dialogul, încurajând pacienții să pună întrebări mai bune și permițând medicilor să ofere răspunsuri bazate pe dovezi, conform logicii modelului.

Această colaborare face ca îngrijirea să pară mai personală. Cu XAI, AI explică, colaborează și sprijină deciziile luate de oameni.

Adaptarea la individ în timp real

Îngrijirea personalizată este un proces continuu care se adaptează pe măsură ce pacienții răspund la tratamente, experimentează efecte secundare sau dezvoltă noi simptome. Sistemele interactive XAI permit modelelor AI să învețe din date noi și să ofere explicații actualizate pentru recomandările lor.

Clinicienii folosesc instrumente dinamice în loc de rapoarte statice, permițându-le să înțeleagă schimbările în timp. De exemplu, dacă un dispozitiv purtabil detectează somn neregulat sau tensiune arterială în creștere, XAI poate arăta cum aceste tipare afectează predicțiile de tratament, susținând intervenția timpurie și ajustările de îngrijire.

Componentele de bază ale XAI în asistența medicală personalizată

Componentele de bază ale XAI se unesc pentru a face din AI un partener activ, transparent și de încredere în livrarea unei îngrijiri cu adevărat personalizate.

Algoritmi interpretabili pentru decizii din viața reală

În centrul XAI stă faptul de a face AI de înțeles în timp ce se menține precizia. În asistența medicală personalizată, acest lucru începe cu alegerea unui algoritm.

Modele interpretabile, cum ar fi arborii de decizie, arată clar cum variabilele influențează deciziile. În contrast, modelele complexe, cum ar fi deep learning, pot fi de asemenea explicate prin tehnici XAI.

Pentru planurile de medicamente personalizate, modelele interpretabile arată cum greutatea și funcția renală afectează recomandările de dozare, crescând încrederea medicilor în sugestiile AI și ajutându-i să adapteze tratamentele eficient.

Explicații vizuale și interactive

Metodele de explicație vizuală, cum ar fi Grad-CAM și hărțile de saliență, sunt cruciale în imagistica medicală. Ele subliniază zonele din scanările RMN sau CT pe care AI se concentrează pentru diagnostic. Aceste instrumente asistă radiologii și ajută pacienții să înțeleagă descoperirile vizual.

Tablourile de bord interactive îmbunătățesc experiența utilizatorului, permițând clinicienilor și pacienților să ajusteze intrările și să vadă recomandările în schimbare, facilitând discuțiile colaborative și implicarea activă.

Medicai integrează explicații vizuale, cum ar fi Grad-CAM, direct în vizualizatorul său de imagini, permițând clinicienilor să evalueze atât rezultatul, cât și raționamentul acestuia într-un flux de lucru integrat.

Învățare prin feedback și rafinament în timp real

Forța AI explicabile moderne constă în capacitatea sa de a învăța continuu din interacțiunile din lumea reală. Sistemele interactive explicabile pot evolua dincolo de predicțiile statice.

Pe măsură ce clinicienii oferă feedback sau condițiile pacienților se schimbă, aceste modele pot adapta ieșirile lor în timp ce explică motivele pentru schimbări. Creează un asistent AI adaptiv care îmbunătățește continuu precizia și rămâne interpretabil.

Tehnici și instrumente în AI explicabilă

Mai multe instrumente cheie facilitează funcția AI explicabile în domeniul sănătății.

Metode independente de model: versatilitate la scară largă

Tehnicile XAI independente de model lucrează cu orice model de învățare automată prin concentrarea asupra analizei ieșirii, nu asupra mecanicii interne. Le face flexibile și aplicabile pe scară largă în sistemele de sănătate.

Două dintre cele mai utilizate tehnici în această categorie sunt:

- SHAP (SHapley Additive Explanations): SHAP, din teoria jocurilor cooperante, atribuie valori de contribuție caracteristicilor în predicții. Ajută la explicarea de ce un pacient cu biomarkeri specifici este mai potrivit pentru Medicamentul A decât B.

- LIME (Local Interpretable Model-agnostic Explanations): LIME simplifică un model în jurul unei predicții specifice, ajutând clinicienii să identifice caracteristicile cheie care influențează acel caz.

Aceste instrumente împuternicesc clinicienii să interpreteze predicțiile pacient cu pacient, ceea ce este crucial pentru explicarea planurilor de tratament în setările de îngrijire extrem de individualizată.

Explicații contrafactuale: explorarea „Ce ar fi dacă”

Contrafactualele sunt o modalitate puternică de a explora rezultatele alternative. Ele răspund la întrebări precum: Ce ar trebui să se schimbe în profilul unui pacient pentru ca AI să recomande un alt tratament?

Acest tip de raționament este intuitiv pentru medici și util în analizele etice. Permite furnizorilor să înțeleagă limita de decizie a modelului AI și să ia în considerare cazuri limită, cum ar fi pacienți care ar putea avea riscuri la margine sau profiluri ambigue.

Oferind acest tip de „testare a scenariului”, contrafactualele adaugă un strat de stabilitate clinică și ajută doctorii să gândească intervenții alternative.

Metode specifice modelului: explicații mai profunde pentru modele specializate

Unele instrumente XAI sunt construite pentru a funcționa cu tipuri specifice de modele, cum ar fi sistemele de deep learning utilizate în imagistica medicală, patologie sau genomică.

De exemplu,

- Grad-CAM (Gradient-weighted Class Activation Mapping): subliniază părți ale unei imagini care au influențat decizia unui model. Este utilizat frecvent în radiologie și oncologie pentru a arăta unde s-a concentrat modelul când a identificat tumori sau leziuni.

- Hărțile de saliență: arată importanța la nivel de pixel în modelele bazate pe imagini. Acestea ajută patologii să interpreteze scanările de biopsie și să înțeleagă cum a fost diagnosticată de AI.

- Vizualizarea caracteristicilor: ajută la interpretarea rețelelor neuronale profunde în domenii non-imagine, afișând răspunsurile neuronului sau stratului la modele specifice, benefic pentru genomică și diagnostic predictiv.

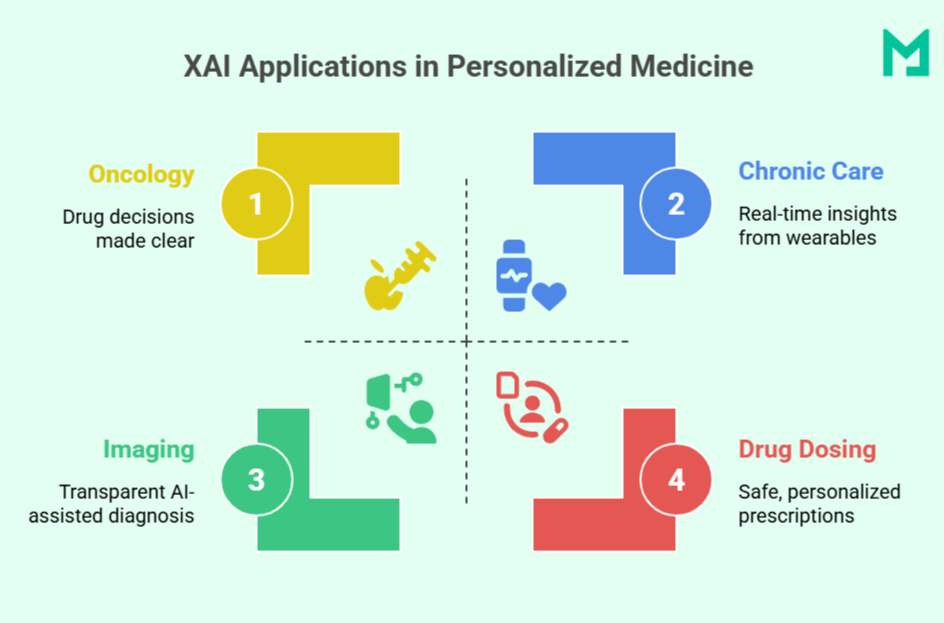

Aplicații specifice ale XAI în tratamentul personalizat

Clarificând „de ce” din spatele „ce”, XAI apropie medicina susținută de AI mai aproape de îngrijirea cotidiană, centrată pe pacient.

Oncologie de precizie

Deciziile de tratament în cancer se bazează din ce în ce mai mult pe profilarea moleculară, stadializarea tumorilor și istoricul pacientului. AI explicabilă (XAI) clarifică modul în care acești factori influențează selecția terapiei.

De exemplu, IBM Watson pentru Oncologie folosește XAI pentru a simplifica deciziile complexe cu justificări clare, legând mutațiile genetice și răspunsurile anterioare de recomandări. Ajută oncologii să alinieze sugestiile AI cu raționamentul clinic și să crescă încrederea pacienților în îngrijirea lor.

Stratificarea riscului și gestionarea bolilor cronice

În îngrijire cronică (de exemplu, diabet, hipertensiune), XAI permite intervenții personalizate prin monitorizarea datelor pacienților de la dispozitive portabile sau EHR-uri în timp real. Explicabilitatea este crucială; instrumente precum SHAP pot arăta dacă un vârf de glucoză a fost datorat unui somn deficitar, dietei sau stresului.

Permite clinicienilor să ajusteze tratamentul cu insight asupra raționamentului modelului, îmbunătățind siguranța și reactivitatea.

Imagini diagnostice și patologie

Deep learning este utilizat pe scară largă în imagistica medicală, dar complexitatea sa poate submina încrederea clinică.

XAI ajută oferind explicații vizuale, cum ar fi Grad-CAM și hărți de saliență, evidențiind zonele cheie în scanări sau lamurii care au influențat diagnosticele AI, cum ar fi nodulii pulmonari sau celulele maligne. Acest lucru ajută radiologii și patologii să verifice constatări, să le explice pacienților și să detecteze potențiale erori ale modelului.

Sisteme de suport al deciziilor clinice (CDSS)

Instrumentele CDSS îmbunătățite de XAI susțin deciziile de tratament în îngrijirea primară și spitale. Spre deosebire de alertele tradiționale, sistemele explicabile precum MediAssist oferă raționament clar, demonstrând cum simptomele, semnele vitale și rezultatele de laborator indică pneumonia în locul bronșitei.

Această transparență ajută clinicienii să ia decizii mai rapide, informate și îmbunătățește acuratețea diagnostică în timp ce reduce oboseala cauzată de alerte.

Dozare de medicamente personalizată și farmacogenomică

Răspunsul la medicamente diferă între indivizi.

XAI îmbunătățește modelele de farmacogenomică pentru a personaliza alegerea și dozarea medicamentelor prin luarea în considerare a markerilor genetici, vârstei și funcției hepatice. Clinicienii primesc recomandări de dozare și insight-uri despre adecvarea lor, făcând prescrierea precisă mai sigură și mai fiabilă.

Beneficii clinice ale XAI în îngrijirea personalizată

AI explicabilă oferă mai mult decât simple predicții exacte.

| Părți interesate | Beneficii cheie | Impact |

| Clinicieni | Înțeleg care variabile conduc deciziile AIValidează și adaptează sugestiile AIMicșorează incertitudinea în diagnostic | Construiește încredere diagnosticăÎncurajează decizii mai rapide, informatePromovează încrederea clinicienilor |

| Pacienți | Primesc explicații clare pentru tratamenteÎnțeleg cum factorii personali influențează îngrijireaSe simt incluși în decizii | Crește încrederea și satisfacțiaÎmbunătățește aderența la tratamentSusține deciziile împărtășite |

| Sisteme de sănătate | Asigură transparența în instrumentele AIIdentifică și abordează bias-ulRespectă standardele legale și etice (ex. GDPR, FDA) | Permite conformitatea cu reglementărileÎmbunătățește siguranța și echitateaÎntărește responsabilitatea |

Abordarea Medicai de a explica imaginile ajută să se închidă decalajul dintre diagnosticele AI și validarea umană, îmbunătățind încrederea clinicianului și implicarea pacientului.

Provocări în implementarea AI explicabile pentru tratamente personalizate

Câteva provocări pot apărea în timp ce se implementează XAI pentru tratamentul personalizat.

Echilibrarea între acuratețe și interpretabilitate

Un compromis comun în XAI este între complexitatea modelului și explicabilitate. Modelele de deep learning ating o mare acuratețe cu date medicale complexe, dar sunt adesea dificil de înțeles pentru clinicieni.

Modelele mai simple, cum ar fi arborii de decizie, sunt mai ușor de interpretat, dar pot lipsi de predicție în cazurile nuanțate. Găsirea echilibrului corect rămâne o provocare, mai ales când viețile sunt în joc.

Lipsa standardizării

Nu există o definiție universală a unui model AI „explicabil,” ceea ce duce la variații în metode, formate și detalii între diferite instrumente. Această inconsistență complică evaluările de încredere pentru furnizorii de sănătate și provoacă aprobările de reglementare, deoarece agențiile trebuie să evalueze fiecare sistem individual fără repere clare.

Integrarea cu fluxurile de lucru clinice

Multe instituții de sănătate se bazează pe sisteme vechi și baze de date izolate, făcând integrarea AI explicabile (XAI) provocatoare.

Integrarea personalizată cu dosarele electronice de sănătate (EHR-uri) poate întârzia implementarea, iar clinicienii au nevoie de timp și de instruire pentru a se adapta și a avea încredere în aceste noi instrumente. Este adesea dificil în medii cu presiune ridicată.

Confidențialitatea și securitatea datelor

XAI necesită date detaliate despre pacienți pentru perspective precise, ceea ce ridică preocupări legate de confidențialitate. Conformitatea cu HIPAA și alte legi este crucială, iar dezvoltatorii trebuie să se asigure că explicațiile nu expun, din greșeală, informații sensibile în timpul testării sau implementării.

Concluzie

AI explicabilă redefinește ce înseamnă să oferi o îngrijire cu adevărat personalizată făcând ca deciziile medicale să fie transparente, de încredere și centrate pe pacient. Într-o lume în care AI devine esențială pentru diagnostic și tratament, platforme precum Medicai deschid calea, asigurându-se că clinicienii nu doar primesc răspunsuri, ci le și înțeleg.

Pe măsură ce asistența medicală evoluează, explicabilitatea nu va fi opțională—va fi așteptată.