KI-generierte Berichte revolutionieren die Radiologie, aber die eigentliche Frage ist nicht, ob KI funktionieren kann. Es ist, ob Radiologen ihr vertrauen können?

Vertrauen in KI-generierte Radiologieberichte aufzubauen bedeutet mehr als nur Genauigkeit. KI in der Radiologie erfordert Transparenz, Nachvollziehbarkeit und nahtlose Integration in Arbeitsabläufe, sodass Klinikern die Überprüfung der Ergebnisse ermöglicht wird.

Erfahre, warum Vertrauen in KI-generierten Radiologieberichten wichtig ist, wie retrieval-augmented generation (RAG) das Vertrauen stärkt und welche Schritte Radiologieteams unternehmen können, um KI sicher zu nutzen.

Warum Vertrauen in KI-generierten Radiologieberichten wichtig ist

In der Radiologie ist Vertrauen alles.

Radiologen und Kliniker verlassen sich auf Berichte für wichtige Entscheidungen, sodass selbst kleine Fehler schwerwiegende Konsequenzen haben können. Ein KI-generierter Bericht, der einen Bruch falsch diagnostiziert, eine Blutung übersieht oder unklar ist, birgt ein direkter Risiko für die Patientensicherheit.

Das Problem ist nicht, dass KI-Modelle nicht leistungsfähig sind. Sie übertreffen häufig Menschen bei spezifischen Aufgaben, aber ihre Zuverlässigkeit kann je nach Kontext variieren.

Große Sprachmodelle (LLMs) können Halluzinationen erzeugen und Ergebnisse generieren, die zwar genau erscheinen, aber klinisch nicht korrekt sind. Dies birgt Risiken für Radiologen und schafft ein herausforderndes Gleichgewicht zwischen Effizienz und Sicherheit. Ohne einen Vertrauensrahmen könnten KI-Berichte Schwierigkeiten haben, in kritischen Bereichen wie Trauma- oder Notfallversorgung akzeptiert zu werden.

Die Studie hob hervor wie gängige Evaluationsmetriken versagten wichtige Fehler in KI-generierten Radiologieberichten zu erkennen. Viele automatisierte Bewertungssysteme, die dazu entwickelt wurden, zu beurteilen, wie „gut“ ein KI-Bericht aussieht, konnten klinische Fehler, einige davon erhebliche, nicht zuverlässig identifizieren.

Dies bedeutet, dass selbst wenn ein Bericht auf dem Papier gut abschneidet, er immer noch gefährliche Ungenauigkeiten enthalten kann, die nur ein ausgebildeter Radiologe erkennen kann.

Diese Lücke unterstreicht die Notwendigkeit vertrauenswürdiger Bewertungsmethoden. Neuere Metriken wie RadGraph F1 und RadCliQ, werden entwickelt, um besser mit dem menschlichen klinischen Urteil in Einklang zu stehen und sicherzustellen, dass die KI-Ausgaben nicht nur auf Lesbarkeit, sondern auch auf diagnostische Genauigkeit gemessen werden.

Ähnlicherweise zeigt die Forschung, dass wenn KI-Systeme mit retrieval-augmented generation (RAG) und domänenspezifischem Wissen, sowohl die Genauigkeit als auch das Vertrauen der Kliniker erheblich steigen.

Mit anderen Worten, Vertrauen basiert nicht nur auf Geschwindigkeit oder technischer Raffinesse. Es hängt von drei miteinander verwobenen Säulen ab:

- Überprüfbare Genauigkeit

- Transparenz, die du verstehen kannst

- Bewertungsmethoden, die die Sicherheit in der realen klinischen Praxis widerspiegeln

Ohne diese könnte KI in der Radiologie eine Haftung anstelle eines hilfreichen Werkzeugs werden. Mit KI-generierten Berichten wird KI jedoch unverzichtbar und ermöglicht es Radiologen, schnellere, sicherere und vertrauensvollere Versorgung zu bieten.

Was ist Retrieval-Augmented Generation und warum funktioniert sie?

Retrieval-Augmented Generation (RAG) verbessert ein Modell wie GPT-4, indem es mit einem Wissensretrieval-System gekoppelt wird. Anstatt sich ausschließlich auf das, was das Modell „erinnert“, zu verlassen, durchsucht es in Echtzeit vertrauenswürdige, domänenspezifische Quellen und nutzt diese Informationen, um einen Bericht zu erstellen.

So basiert KI in der Radiologie bei der Vorhersage von Textmustern auf geprüfter Literatur, institutionellen Protokollen oder von Experten kuratierten Richtlinien.

Dieser Ansatz adressiert direkt zwei der größten Hindernisse für Vertrauen:

- Genauigkeit: Durch das Abrufen von Kontext aus validierten Quellen verringert die KI Halluzinationen und liefert konsistentere diagnostische Sprache.

- Transparenz: RAG-Systeme können die Quellen angeben, die sie verwendet haben, und bieten Radiologen damit eine Möglichkeit, die Begründung hinter einer Empfehlung zu überprüfen.

Was die Forschung über KI in der Radiologie nahelegt?

Eine aktuelle Studie hat gezeigt, wie GPT-4, als es mit Wissen über Traumatologie aus der RadioGraphics Top Ten Reading List, 100 % korrekte Diagnosen, 96 % Klassifikationsgenauigkeit und 87 % Bewertungsgenauigkeit erreichte.

Im Vergleich dazu lag einfaches GPT-4 ohne Retrieval-Unterstützung deutlich zurück, insbesondere bei Klassifikations- und Bewertungsaufgaben. Was jedoch am meisten auffiel, war das Feedback der Kliniker: Das Retrieval-unterstützte Modell erzielte konstant eine mediane Vertrauensbewertung von 5,0 für Erklärungen und zitierte Quellen.

Ein ähnliches Proof-of-Concept-System wurde für die gastrointestinale Radiologie entwickelt, bekannt als Gastrointestinal Imaging Chatbot (GIA-CB). Es erweiterte GPT-4 mit autoritativen GI-spezifischen Ressourcen. Das Ergebnis war beeindruckend: 78 % Genauigkeit in der Differenzialdiagnose im Vergleich zu 54 % mit generischem GPT-4.

Dieser Befund hebt hervor, warum RAG in der Radiologie so gut funktioniert. Radiologen können sehen, woher die Informationen stammen, verstehen, wie sie angewendet wurden und letztendlich entscheiden, ob sie die Schlussfolgerung der KI unterstützen möchten.

Wesentliche Prinzipien für den Aufbau von Vertrauen in KI-generierte Radiologieberichte

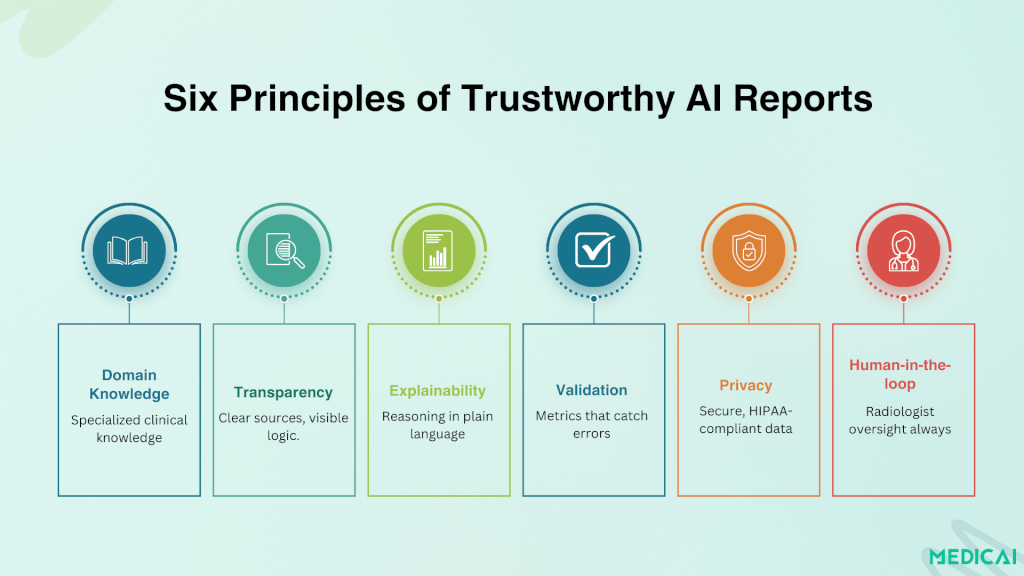

Aktuelle Forschungen identifizieren sechs wesentliche Prinzipien, die entscheidend sind, um die Akzeptanz von KI-generierten Berichten in der klinischen Praxis zu fördern.

Domänenspezifisches Wissen

Generische KI-Modelle sind zu breit gefasst, um für die klinische Versorgung zuverlässig zu sein. Durch den Fokus auf spezielle Datensätze, sei es bei Trauma, Gastrointestinal- oder Neuroimaging, können KI-Systeme Ergebnisse liefern, die mit der Expertise der Radiologen übereinstimmen.

Quellenbasierte Transparenz

Berichte sind viel vertrauenswürdiger, wenn sie ihre Arbeit zeigen. RAG-gestützte Systeme bieten Zitationen aus Lehrbüchern, Richtlinien oder institutionellen Protokollen. Radiologen können die Logik hinter den Schlussfolgerungen nachvollziehen und die KI von einer „Black Box“ in einen transparenten Partner verwandeln.

Plattformen wie Medicai stellen sicher, dass Berichte überprüfbar sind, mit Prüfpunkten und Anmerkungen, die im PACS-Viewer sichtbar sind.

Erklärbarkeit, die klinischem Denken gerecht wird

Radiologen wollen keine abstrakten Visualisierungen oder vagen Wahrscheinlichkeitswerte. Sie wollen Erklärungen in klarer, strukturierter klinischer Sprache, die der Argumentation entspricht, die sie in ihren eigenen Berichten verwenden würden.

Modelle, die Befunde zusammen mit anatomischen Referenzen, Verletzungs klassifikationen und Zitationen präsentieren, schaffen mehr Vertrauen.

Starke Validierung & bedeutungsvolle Metriken

Oberflächliche Bewertungssysteme sind nicht ausreichend. Werkzeuge wie RadGraph F1 und RadCliQ zeigen, dass die Bewertung klinisch signifikante Fehler verfolgen muss. Vertrauen wächst, wenn Berichte gegen Metriken validiert werden, die zeigen, wie Radiologen tatsächlich praktizieren.

Datenschutzsichere Bereitstellung

Datensicherheit ist ebenso zentral für Vertrauen wie Genauigkeit. Lokale oder institutionelle RAG-Implementierungen ermöglichen es der KI, innerhalb sicherer Krankenhausumgebungen zu arbeiten und dabei die Einhaltung von HIPAA und GDPR sicherzustellen, während die Kontrolle über sensible Patientendaten beibehalten wird.

Mensch-gestützter Einsatz

KI ist am effektivsten, wenn sie Radiologen unterstützt und nicht ersetzt. Die endgültige Verantwortung sollte beim Kliniker bleiben, der die KI-generierten Ergebnisse überprüfen, bearbeiten und genehmigen kann. Dieser Workflow schafft ein Gleichgewicht zwischen Verantwortung und Effizienz.

Praktische Schritte für Radiologieteams

Den Abstand zwischen dem Verständnis von Vertrauensprinzipien und deren praktischer Anwendung zu überbrücken, ist entscheidend für Kliniken, Bildgebungszentren und Radiologiegruppen, die KI-generierte Berichte in Betracht ziehen.

Beginne mit Spezialpiloten

Anstatt KI breitflächig einzuführen, beginne mit einem eng fokussierten Bereich wie Trauma, Thoraxbildgebung oder gastrointestinalen Fällen. Proof-of-Concept-Projekte zeigen, dass spezialisierten KI im Vergleich zu allgemein einsetzbaren Werkzeugen höhere Genauigkeit und die Zustimmung der Klinikern erzielen.

Integriere Erklärbarkeitsfunktionen

Wähle KI-Lösungen, die ihre Argumentation darstellen. Suche nach Systemen, die Zitationen bereitstellen, relevante Bildbefunde hervorheben oder strukturierte Begründungen einfügen. Dies hilft Radiologen, Schlussfolgerungen zu überprüfen und Vertrauen in den Bericht aufzubauen.

Verwende Bewertungsmetriken, die die klinische Realität widerspiegeln

Übernimm Werkzeuge wie RadGraph F1 oder RadCliQ zur internen Validierung. Diese Metriken bewerten nicht nur die sprachliche Ähnlichkeit, sondern auch, ob die KI Fehler macht, die die klinische Entscheidungsfindung beeinträchtigen würden. Mache die Bewertung zu einem kontinuierlichen Prozess, nicht zu einem einmaligen Test.

Sorge für Datenschutz und Compliance

Arbeite mit Anbietern oder entwickle interne Lösungen, die Datensicherheit priorisieren. Lokale oder institutionell gehostete RAG-Systeme können verhindern, dass sensible Patientendaten sichere Umgebungen verlassen und gleichzeitig modernste KI-Funktionalitäten liefern.

Halte Radiologen im Prozess

Positioniere KI als Entscheidungshilfetool, nicht als Ersatz. Dieser Mensch-in-der-Schleife-Ansatz beruhigt Kliniker und Patienten gleichermaßen, dass KI die Versorgung verbessert, ohne die berufliche Verantwortung zu beeinträchtigen.

Baue KI-Kompetenz im Team auf

Biete Schulungen und Diskussionen an, die Radiologen helfen, sowohl die Fähigkeiten als auch die Grenzen von KI-generierten Berichten zu verstehen. Ein Team, das weiß, wann es vertrauen und wann es in Frage stellen sollte, ist viel besser in der Lage, KI sicher zu nutzen.

Fazit

Vertrauen ist das Fundament der KI in der Radiologie. Genauigkeit allein reicht nicht aus; Berichte müssen transparent, überprüfbar und nahtlos in klinische Arbeitsabläufe integriert sein.

Retrieval-augmented generation, Erklärbarkeit und starke Bewertungsmetriken zeigen, wie KI sich von einer Black Box zu einem vertrauenswürdigen Partner entwickeln kann.

Mit Plattformen wie Medicai, die diese Prinzipien in PACS-Umgebungen integrieren, können Radiologen KI mit Vertrauen übernehmen. Wir helfen, Geschwindigkeit und Effizienz zu gewinnen, während die menschliche Expertise im Mittelpunkt jeder Entscheidung bleibt.