Que se passerait-il si votre médecin vous remettait un plan de traitement généré par l’IA, sans expliquer pourquoi ? Lui feriez-vous confiance ?

Dans le paysage des soins de santé axé sur les données d’aujourd’hui, l’IA progresse dans le diagnostic des maladies et l’orientation des traitements personnalisés. Mais sans transparence, même l’IA la plus précise peut susciter des doutes.

L’IA explicable (XAI) offre des informations claires et lisibles par l’homme sur la manière dont les décisions sont prises. Elle transforme l’IA d’une boîte noire en un outil de confiance pour les cliniciens et les patients.

Explorons comment l’XAI redéfinit la médecine personnalisée, pourquoi cela importe et ses défis.

Comprendre l’IA explicable (XAI)

L’IA explicable (XAI) désigne des systèmes d’intelligence artificielle conçus pour rendre leurs processus de prise de décision transparents et compréhensibles pour les humains. Contrairement aux modèles traditionnels de « boîte noire » qui fournissent des résultats sans révéler leur logique, l’XAI clarifie comment les entrées influencent les résultats.

Cette clarté est essentielle dans le domaine de la santé. Lorsqu’un système d’IA propose un diagnostic ou un traitement, les médecins et les patients doivent comprendre pourquoi. Des outils comme SHAP (Shapley Additive Explanations), LIME (Local Interpretable Model-agnostic Explanations) et Grad-CAM sont utiles ici.

Ces méthodes révèlent quelles caractéristiques, points de données ou régions d’image ont contribué à la décision de l’IA, rendant le processus interprétable pour une utilisation clinique.

En offrant des explications sous forme visuelle, textuelle ou numérique, l’XAI transforme des résultats complexes de l’IA en informations exploitables. Cette transparence aide à aligner les outils d’IA avec le raisonnement médical et l’intuition humaine, tous deux essentiels dans les soins aux patients.

Pourquoi les soins de santé exigent l’explicabilité

L’explicabilité joue un rôle critique dans l’établissement de la confiance. Des recherches montrent que les modèles d’IA opaques réduisent l’adhésion au traitement et affaiblissent la collaboration entre patients et prestataires. Lorsque les systèmes d’IA manquent de raisonnement pour leurs résultats, les cliniciens ont du mal à valider ou à défendre les recommandations aux patients.

Le traitement personnalisé nécessite d’adapter les soins à l’historique, à la biologie et aux préférences de chaque individu. Sans comprendre comment un système d’IA évalue ces facteurs, la personnalisation perd tout sens.

L’explicabilité aide à répondre aux normes légales et éthiques, comme le RGPD de l’UE, qui souligne les droits des individus de comprendre les décisions automatisées. Pour les prestataires de soins de santé, cela signifie choisir des outils d’IA capables d’expliquer leur raisonnement.

En résumé, les soins de santé exigent une IA explicable parce que :

- La sécurité des patients nécessite de la clarté, pas des suppositions.

- La confiance clinique se construit sur la compréhension, pas sur l’automatisation.

- Les normes juridiques exigent transparence et responsabilité.

Pourquoi le traitement personnalisé nécessite l’XAI

L’XAI donne du contexte aux décisions de l’IA. L’IA explicable garantit que la personnalisation ne se fait pas silencieusement en arrière-plan, mais se fait ouvertement, avec clarté et intention.

Lorsqu’un système recommande un médicament de chimiothérapie spécifique plutôt qu’un autre, ou ajuste la posologie d’insuline pour un patient diabétique, les outils XAI peuvent montrer quels facteurs ont conduit à ce choix.

Ces explications aident les médecins à comprendre et à communiquer les recommandations plus clairement au patient. Les patients doivent comprendre les compromis des traitements à long terme dans les soins chroniques et en oncologie.

Confiance, Adhésion et Décisions Partagées

La confiance est la base de la médecine personnalisée. Les patients qui ne comprennent pas pourquoi un traitement est spécifiquement choisi pour eux sont plus susceptibles de le remettre en question ou de l’éviter complètement. C’est là que l’XAI entre en jeu.

Des études montrent que lorsque les patients reçoivent des justifications transparentes et compréhensibles pour les décisions médicales, notamment celles générées par l’IA, ils sont plus susceptibles de s’en tenir à ces traitements.

En revanche, des recommandations vagues ou opaques entraînent des doutes, une conformité réduite et même un abandon du traitement.

L’XAI améliore la prise de décision partagée en permettant aux cliniciens et aux patients de comprendre la raison d’être des recommandations de l’IA. Elle favorise le dialogue, encourageant les patients à poser de meilleures questions et permettant aux médecins de fournir des réponses basées sur des preuves selon la logique du modèle.

Cette collaboration rend les soins plus personnels. Avec l’XAI, l’IA explique, collabore et soutient les décisions prises par les humains.

S’adapter à l’individu en temps réel

Les soins personnalisés sont un processus continu qui s’adapte au fur et à mesure que les patients réagissent aux traitements, éprouvent des effets secondaires ou développent de nouveaux symptômes. Les systèmes XAI interactifs permettent aux modèles d’IA d’apprendre à partir de nouvelles données et de fournir des explications mises à jour pour leurs recommandations.

Les cliniciens utilisent des outils dynamiques au lieu de rapports statiques, leur permettant de comprendre les changements au fil du temps. Par exemple, si un appareil portable détecte un sommeil irrégulier ou une pression artérielle élevée, l’XAI peut montrer comment ces schémas influencent les prédictions de traitement, soutenant l’intervention précoce et les ajustements de soins.

Composants clés de l’XAI dans les soins de santé personnalisés

Les composants clés de l’XAI se réunissent pour faire de l’IA un partenaire actif, transparent et de confiance dans la fourniture de soins véritablement personnalisés.

Algorithmes interprétables pour des décisions concrètes

Au cœur de l’XAI se trouve le fait de rendre l’IA compréhensible tout en maintenant la précision. Dans les soins de santé personnalisés, cela commence par le choix d’un algorithme.

Les modèles interprétables, comme les arbres de décision, montrent clairement comment les variables influencent les décisions. En revanche, des modèles complexes, tels que l’apprentissage profond, peuvent également être expliqués par des techniques XAI.

Pour les plans médicamenteux personnalisés, les modèles interprétables démontrent comment le poids et la fonction rénale influencent les recommandations de dosage, augmentant la confiance des médecins dans les suggestions de l’IA et les aidant à adapter efficacement les traitements.

Explications visuelles et interactives

Les méthodes d’explication visuelle comme Grad-CAM et les cartes de saillance sont cruciales dans l’imagerie médicale. Elles mettent en évidence les zones dans les IRM ou les scans CT sur lesquelles l’IA se concentre pour les diagnostics. Ces outils aident les radiologues et aident les patients à comprendre les résultats visuellement.

Les tableaux de bord interactifs améliorent l’expérience utilisateur en permettant aux cliniciens et aux patients de modifier les entrées et de voir les recommandations changeantes, favorisant ainsi des discussions collaboratives et un engagement actif.

Medicai intègre des explications visuelles comme Grad-CAM directement dans son visualiseur d’images, permettant aux cliniciens d’évaluer à la fois le résultat et son raisonnement dans un flux de travail fluide.

Apprendre par le feedback et le raffinement en temps réel

La force de l’XAI moderne réside dans sa capacité à apprendre continuellement à partir d’interactions du monde réel. Les systèmes explicables interactifs peuvent évoluer au-delà des prédictions statiques.

À mesure que les cliniciens donnent leur avis ou que les conditions des patients changent, ces modèles peuvent adapter leurs résultats tout en expliquant les raisons de ces changements. Cela crée un assistant IA adaptatif qui améliore continuellement la précision et reste interprétable.

Techniques et outils dans l’IA explicable

Plusieurs outils clés facilitent le fonctionnement de l’IA explicable dans le domaine de la santé.

Méthodes indépendantes du modèle : polyvalence généralisée

Les techniques d’XAI indépendantes du modèle fonctionnent avec n’importe quel modèle d’apprentissage automatique en se concentrant sur l’analyse des résultats plutôt que sur les mécanismes internes. Cela les rend flexibles et largement applicables dans les systèmes de santé.

Deux des techniques les plus largement utilisées dans cette catégorie sont :

- SHAP (SHapley Additive Explanations) : SHAP, issu de la théorie des jeux coopératifs, attribue des valeurs de contribution aux caractéristiques dans les prédictions. Cela aide à expliquer pourquoi un patient avec des biomarqueurs spécifiques est plus adapté au médicament A qu’au médicament B.

- LIME (Local Interpretable Model-agnostic Explanations) : LIME simplifie un modèle autour d’une prédiction spécifique, aidant les cliniciens à identifier les caractéristiques clés influençant ce cas.Ces outils permettent aux cliniciens d’interpréter les prédictions patient par patient, ce qui est crucial pour expliquer les plans de traitement dans des environnements de soins hautement individualisés.

These tools empower clinicians to interpret predictions patient by patient, which is crucial for explaining treatment plans in highly individualized care settings.

Explications contrefactuelles : explorer les « Et si »

Les contrefactuels sont un moyen puissant d’explorer des résultats alternatifs. Ils répondent à des questions telles que : Que faudrait-il changer dans le profil d’un patient pour que l’IA recommande un traitement différent ?

Ce type de raisonnement est intuitif pour les médecins et utile lors des revues éthiques. Cela permet aux prestataires de comprendre la frontière de décision du modèle d’IA et de considérer des cas limites, tels que des patients pouvant présenter des risques limites ou des profils ambigus.

En fournissant ce type de « test de scénario », les contrefactuels ajoutent une couche de stabilité clinique et aident les médecins à réfléchir à des interventions alternatives.

Méthodes spécifiques au modèle : explications plus profondes pour des modèles spécialisés

Certains outils d’XAI sont conçus pour travailler avec des types spécifiques de modèles, tels que ceux utilisés en apprentissage profond dans l’imagerie médicale, la pathologie ou la génomique.

Par exemple,

- Grad-CAM (Gradient-weighted Class Activation Mapping) : il met en évidence des parties d’une image qui ont influencé la décision d’un modèle. Il est couramment utilisé en radiologie et en oncologie pour montrer où le modèle s’est concentré lors de l’identification de tumeurs ou de lésions.: it highlights parts of an image that influenced a model’s decision. It is commonly used in radiology and oncology to show where the model focused when identifying tumors or lesions.

- Cartes de saillance : Montrent l’importance au niveau pixel dans les modèles basés sur l’image. Celles-ci aident les pathologistes à interpréter les scans de biopsies et à comprendre comment l’IA a établi son diagnostic.Visualisation des caractéristiques : elle aide à interpréter les réseaux neuronaux profonds dans des domaines non liés à l’image en affichant les réponses des neurones ou des couches à des motifs spécifiques, bénéfique pour la génomique et le diagnostic prédictif.

- Feature Visualization: it aids in interpreting deep neural networks in non-image domains by displaying neuron or layer responses to specific patterns, beneficial for genomics and predictive diagnostics.

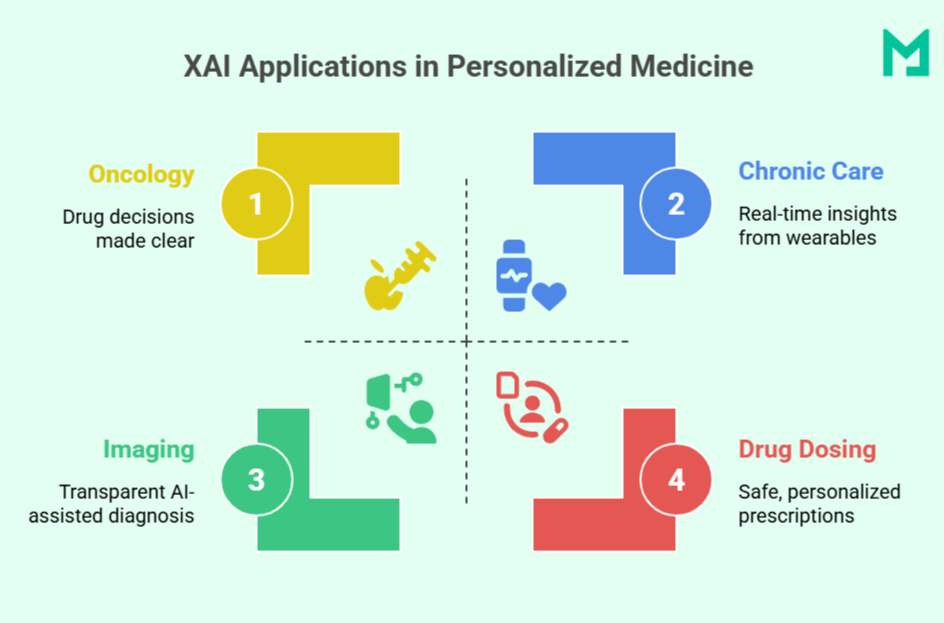

Applications spécifiques de l’XAI dans le traitement personnalisé

En clarifiant le « pourquoi » derrière le « quoi », l’XAI rapproche la médecine alimentée par l’IA des soins quotidiens centrés sur le patient.

Oncologie de précision

Les décisions de traitement du cancer reposent de plus en plus sur le profilage moléculaire, le stade des tumeurs et l’historique des patients. L’IA explicable (XAI) clarifie comment ces facteurs influencent la sélection des thérapies. decisions increasingly rely on molecular profiling, tumor staging, and patient history. Explainable AI (XAI) clarifies how these factors affect therapy selection.

Par exemple, IBM Watson for Oncology utilise l’XAI pour simplifier des décisions complexes avec des justifications claires, liant mutations génétiques et réponses passées aux recommandations. Cela aide les oncologues à aligner les suggestions de l’IA avec le raisonnement clinique et renforce la confiance des patients dans leurs soins.

Stratification des risques et gestion des maladies chroniques

Dans les soins chroniques (par exemple, diabète, hypertension), l’XAI permet des interventions personnalisées en surveillant les données des patients à partir d’appareils connectés ou de DSE en temps réel. L’explicabilité est cruciale ; des outils comme SHAP peuvent montrer si une élévation de glucose était due à un mauvais sommeil, à une alimentation inappropriée ou au stress.

Cela permet aux cliniciens d’ajuster le traitement avec un aperçu du raisonnement du modèle, améliorant la sécurité et la réactivité.

Imagerie diagnostique et pathologie

L’apprentissage profond est largement utilisé dans l’imagerie médicale, mais sa complexité peut nuire à la confiance clinique.

L’XAI aide en fournissant des explications visuelles, telles que Grad-CAM et les cartes de saillance, mettant en évidence des zones clés dans des scans ou des lames qui ont influencé les diagnostics de l’IA, tels que des nodules pulmonaires ou des cellules malignes. Cela aide les radiologues et les pathologistes à vérifier les résultats, à les expliquer aux patients et à repérer d’éventuelles erreurs de modèle.

Systèmes d’aide à la décision clinique (CDSS)

Les outils CDSS améliorés par l’XAI soutiennent les décisions de traitement dans les soins primaires et les hôpitaux. Contrairement aux alertes traditionnelles, les systèmes explicables comme MediAssist offrent un raisonnement clair, démontrant comment les symptômes, les signes vitaux et les résultats de laboratoire indiquent une pneumonie plutôt qu’une bronchite.

Cette transparence aide les cliniciens à prendre des décisions plus rapides et éclairées, et améliore la précision diagnostique tout en réduisant la fatigue des alertes.

Dosage médicamenteux personnalisé et pharmacogénomique

La réponse aux médicaments varie d’une personne à l’autre.

L’XAI renforce les modèles pharmacogénomiques pour personnaliser le choix de médicament et le dosage en tenant compte des marqueurs génétiques, de l’âge et de la fonction hépatique. Les cliniciens reçoivent des recommandations de dosage et des informations sur leur pertinence, rendant la prescription précise plus sûre et plus fiable.

Bénéfices cliniques de l’XAI dans les soins personnalisés

L’IA explicable offre plus que de simples prédictions précises.

| Parties prenantes | Bénéfices clés | Impact |

| Cliniciens | Comprendre quelles variables influencent les décisions de l’IAValider et adapter les suggestions de l’IARéduire l’incertitude dans le diagnostic | Renforce la confiance diagnostiqueEncourage des décisions plus rapides et informéesFavorise la confiance des cliniciens |

| Patients | Recevoir des explications claires pour les traitementsComprendre comment les facteurs personnels affectent les soinsSe sentir inclus dans les décisions | Renforce la confiance et la satisfactionAméliore l’adhésion aux traitementsSoutient la prise de décision partagée |

| Systèmes de santé | Assurer la transparence des outils d’IADétecter et aborder les biaisSe conformer aux normes légales et éthiques (par exemple, RGPD, FDA) | Permettre la conformité réglementaireAméliorer la sécurité et l’équitéRenforcer la responsabilité |

L’approche de Medicai en matière d’imagerie explicable aide à combler le fossé entre les diagnostics par IA et la validation humaine, renforçant la confiance des cliniciens et l’engagement des patients.

Défis dans la mise en œuvre de l’IA explicable pour le traitement personnalisé

Quelques défis peuvent survenir lors de la mise en œuvre de l’XAI pour le traitement personnalisé.

Équilibrer précision et interprétabilité

Un compromis commun dans l’XAI se situe entre la complexité des modèles et leur explicabilité. Les modèles d’apprentissage profond atteignent une grande précision avec des données médicales complexes, mais sont souvent difficiles à comprendre pour les cliniciens.

Des modèles plus simples, comme les arbres de décision, sont plus faciles à interpréter mais peuvent manquer de puissance prédictive dans des cas nuancés. Trouver le bon équilibre reste un défi, surtout lorsque des vies sont en jeu.

Manque de standardisation

Il n’existe pas de définition universelle d’un modèle d’IA « explicable », ce qui entraîne des variations dans les méthodes, formats et détails à travers différents outils. Cette incohérence complique les évaluations de confiance pour les prestataires de soins de santé et challenge les approbations réglementaires, car les agences doivent évaluer chaque système individuellement sans critères d’évaluation clairs.

Intégration dans les flux de travail cliniques

De nombreuses institutions de santé s’appuient sur des systèmes hérités et des bases de données isolées, rendant l’intégration de l’IA explicable (XAI) difficile.

Une intégration personnalisée avec les dossiers de santé électroniques (DSE) peut retarder la mise en œuvre, et les cliniciens ont besoin de temps et de formation pour s’adapter et avoir confiance dans ces nouveaux outils. Cela reste souvent difficile dans des environnements à forte pression.

Confidentialité et sécurité des données

L’XAI nécessite des données détaillées sur les patients pour des informations précises, soulevant des préoccupations en matière de confidentialité. La conformité au HIPAA et autres lois est cruciale, et les développeurs doivent s’assurer que les explications ne dévoilent pas involontairement des informations sensibles lors des tests ou du déploiement.

Conclusion

L’IA explicable redéfinit ce que signifie fournir des soins véritablement personnalisés en rendant les décisions médicales transparentes, dignes de confiance et centrées sur le patient. Dans un monde où l’IA devient essentielle pour le diagnostic et le traitement, des plateformes comme Medicai ouvrent la voie en veillant à ce que les cliniciens ne reçoivent pas seulement des réponses, mais les comprennent également.

À mesure que les soins de santé évoluent, l’explicabilité ne sera pas facultative – elle sera attendue.