Les rapports générés par l’IA redéfinissent la radiologie, mais la vraie question n’est pas de savoir si l’IA peut fonctionner. C’est de savoir si les radiologues peuvent lui faire confiance ?

Établir la confiance dans les rapports de radiologie générés par l’IA signifie plus que la précision. L’IA en radiologie nécessite de la transparence, de l’explicabilité et une intégration fluide dans les flux de travail, permettant aux cliniciens de vérifier les résultats.

Découvrez pourquoi la confiance est importante dans les rapports de radiologie générés par l’IA, comment la génération augmentée par récupération (RAG) renforce la confiance, et quelles étapes les équipes de radiologie peuvent prendre pour adopter l’IA en toute sécurité.

Pourquoi la confiance est essentielle dans les rapports de radiologie générés par l’IA

En ce qui concerne la radiologie, la confiance est primordiale.

Les radiologues et les cliniciens s’appuient sur des rapports pour des décisions cruciales, donc même des erreurs mineures peuvent avoir des conséquences graves. Un rapport généré par l’IA qui ne diagnostique pas correctement une fracture, qui passe à côté d’une hémorragie ou qui est flou représente un risque direct pour la sécurité des patients.

Le problème n’est pas que les modèles d’IA manquent de puissance. Ils surpassent souvent les humains dans des tâches spécifiques, mais leur fiabilité peut varier en fonction du contexte.

Les grands modèles de langage (LLMs) peuvent halluciner, générant des résultats qui semblent exacts mais ne sont pas cliniquement corrects. Cela pose des risques pour les radiologues, créant un équilibre difficile entre efficacité et sécurité. Sans un cadre de confiance, les rapports d’IA peuvent avoir du mal à obtenir une acceptation dans des domaines critiques, tels que les soins d’urgence ou les traumatismes.

L’étude a mis en évidence comment les métriques d’évaluation courantes échouaient à détecter des erreurs importantes dans les rapports de radiologie générés par l’IA. De nombreux systèmes de notation automatisés, conçus pour évaluer à quel point un rapport IA est « bon », n’ont pas réussi à identifier de manière fiable les erreurs cliniques, certaines étant significatives.

Cela signifie que même lorsqu’un rapport obtient de bons résultats sur le papier, il peut encore contenir des inexactitudes dangereuses que seul un radiologue formé peut repérer.

Cet écart souligne la nécessité de méthodes d’évaluation fiables. De nouvelles métriques, telles que RadGraph F1 et RadCliQ, sont en cours de développement pour mieux s’aligner sur le jugement clinique humain, garantissant que la sortie de l’IA est mesurée non seulement pour sa lisibilité, mais aussi pour sa précision diagnostique.

De même, des études montrent que lorsque les systèmes d’IA sont améliorés avec la génération augmentée par récupération (RAG) et des connaissances spécifiques au domaine, tant la précision que la confiance des cliniciens augmentent de manière significative.

En d’autres termes, la confiance ne repose pas uniquement sur la rapidité ou la sophistication technique. Elle dépend de trois piliers interconnectés :

- Précision que vous pouvez vérifier

- Transparence que vous pouvez comprendre

- Méthodes d’évaluation qui reflètent la sécurité clinique dans le monde réel

Sans cela, l’IA en radiologie pourrait devenir une responsabilité plutôt qu’un outil utile. Cependant, avec des rapports générés par l’IA, l’IA devient essentielle, permettant aux radiologues de fournir des soins plus rapides, plus sûrs et plus confiants.

Qu’est-ce que la génération augmentée par récupération et pourquoi ça fonctionne

Génération augmentée par récupération (RAG) améliore un modèle comme GPT-4 en l’associant à un système de récupération de connaissances. Au lieu de se fier uniquement à ce que le modèle « se souvient », il recherche en temps réel des sources fiables et spécifiques au domaine et utilise cette preuve pour générer un rapport.

Ainsi, en radiologie, lorsque l’IA prédit des modèles de texte, elle fonde ses conclusions sur des publications évaluées par des pairs, des protocoles institutionnels ou des directives élaborées par des experts.

Cette approche aborde directement deux des plus grands obstacles à la confiance :

- Précision: En récupérant le contexte à partir de sources validées, l’IA réduit les hallucinations et livre un langage diagnostique plus cohérent.

- Transparence: Les systèmes RAG peuvent citer les sources qu’ils ont utilisées, fournissant aux radiologues un moyen de vérifier le raisonnement derrière une recommandation.

Quels sont les résultats de la recherche sur l’IA en radiologie ?

Une étude récente a démontré comment GPT-4, lorsqu’il était amélioré par des connaissances en radiologie traumatique provenant de la RadioGraphics Top Ten Reading List, a atteint un taux de diagnostic correct de 100 %, une précision de classification de 96 % et une précision de notation de 87 %.

En comparaison, un GPT-4 standard sans support de récupération a significativement accusé du retard, surtout dans les tâches de classification et de notation. Ce qui s’est le plus démarqué, cependant, c’était le retour des cliniciens : le modèle augmentée par récupération a constamment obtenu un score de confiance médian de 5,0 pour les explications et les sources citées.

Un système similaire de preuve de concept a été développé pour la radiologie gastro-intestinale, connu sous le nom de Gastrointestinal Imaging Chatbot (GIA-CB). Il a amélioré GPT-4 avec des ressources GI spécifiques et autorisées. Le résultat était impressionnant : 78 % de précision dans les diagnostics différentiels, contre 54 % avec un GPT-4 générique.

Cette découverte souligne pourquoi la RAG fonctionne si bien en radiologie. Les radiologues peuvent voir d’où proviennent les informations, comprendre comment elles ont été appliquées, et finalement décider s’ils soutiennent la conclusion de l’IA.

Principes Clés pour Établir la Confiance dans les Rapports de Radiologie Générés par l’IA

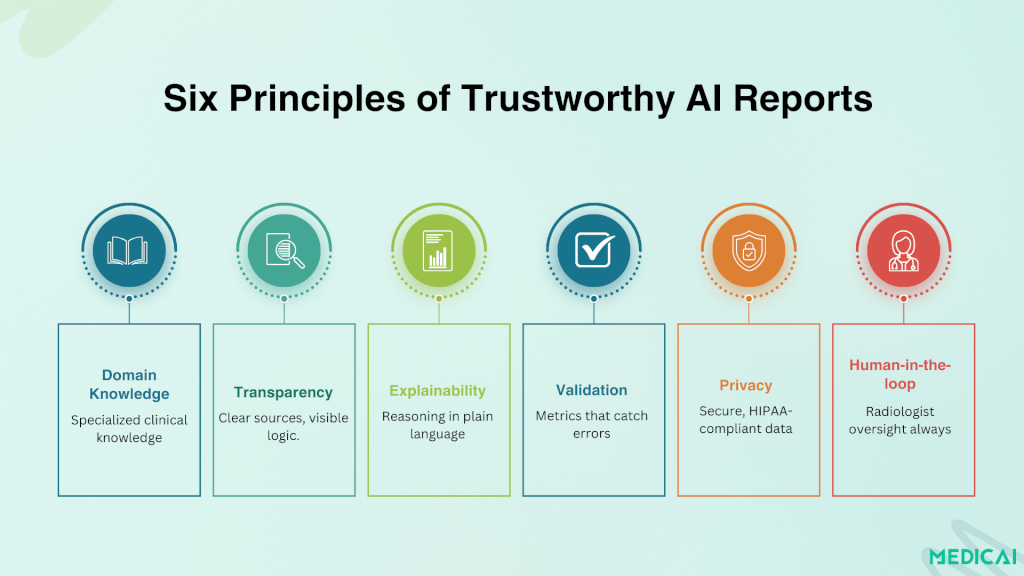

Des recherches récentes identifient six principes clés vitaux pour encourager l’adoption des rapports générés par l’IA dans la pratique clinique.

Connaissances Spécifiques au Domaine

Les modèles IA génériques sont trop larges pour être fiables pour les soins cliniques. En se concentrant sur des ensembles de données de sous-spécialité, qu’il s’agisse de traumatologie, de gastro-entérologie ou de neuroimagerie, les systèmes d’IA peuvent délivrer des résultats qui s’alignent avec l’expertise attendue par les radiologues.

Transparence Justifiée par les Sources

Les rapports sont beaucoup plus fiables lorsqu’ils montrent leur travail. Les systèmes habilités par la RAG fournissent des citations provenant de manuels, de directives ou de protocoles institutionnels. Les radiologues peuvent tracer la logique derrière les conclusions, transformant l’IA d’une « boîte noire » en un collaborateur transparent.

Des plateformes comme Medicai garantissent que les rapports sont vérifiables, avec des pistes d’audit et des annotations visibles dans le visualiseur PACS.

Explicabilité Correspondant à la Pensée Clinique

Les radiologues ne veulent pas de visuels abstraits ou de scores de probabilité vagues. Ils veulent des explications en langage clinique clair et structuré, un langage qui reflète le raisonnement qu’ils incluraient dans leurs propres rapports.

Les modèles qui présentent des résultats aux côtés de références anatomiques, de classifications de blessures et de citations renforcent la confiance.

Validation Rigoriste & Indicateurs Significatifs

Les systèmes de notation superficiels ne suffisent pas. Des outils comme RadGraph F1 et RadCliQ montrent que l’évaluation doit suivre les erreurs cliniques significatives. La confiance croît lorsque les rapports sont validés par des indicateurs qui reflètent comment les radiologues pratiquent réellement.

Déploiement Sûr pour la Vie Privée

La sécurité des données est aussi centrale à la confiance que la précision. Les implémentations de la RAG locales ou institutionnelles permettent à l’IA de fonctionner dans des environnements hospitaliers sécurisés, garantissant la conformité avec HIPAA et GDPR tout en maintenant le contrôle sur les données sensibles des patients.

Supervision par l’Humain

L’IA est la plus efficace lorsqu’elle complète, et ne remplace pas, les radiologues. La responsabilité finale doit rester au clinicien, qui peut examiner, modifier et approuver les résultats générés par l’IA. Cet flux de travail équilibre responsabilité et efficacité.

Étapes Pratiques pour les Équipes de Radiologie

Combler le fossé entre la compréhension des principes de confiance et l’application pratique est crucial pour les hôpitaux, les centres d’imagerie et les groupes de radiologie envisageant des rapports générés par l’IA.

Commencez par des Pilotes de Sous-spécialité

Au lieu de déployer l’IA de manière générale, commencez par un domaine de concentration étroit tel que les traumatismes, l’imagerie thoracique ou les cas gastro-intestinaux. Les projets de preuve de concept montrent que l’IA axée sur une sous-spécialité atteint une meilleure précision et un soutien des cliniciens comparativement aux outils à usage général.

Intégrez des Fonctionnalités d’Explicabilité

Choisissez des solutions d’IA qui montrent leur raison. Recherchez des systèmes qui fournissent des citations, mettent en évidence des résultats d’images pertinents ou incluent des justifications structurées. Cela aide les radiologues à vérifier les conclusions et à se sentir confiants dans l’approbation du rapport.

Utilisez des Métriques d’Évaluation qui Reflètent la Réalité Clinique

Adoptez des outils comme RadGraph F1 ou RadCliQ pour la validation interne. Ces indicateurs évaluent non seulement la similitude linguistique, mais également si l’IA commet des erreurs qui impacteraient la prise de décision clinique. Faites de l’évaluation un processus continu, pas un test unique.

Assurez la Confidentialité et la Conformité

Travaillez avec des fournisseurs ou concevez des solutions internes qui priorisent la sécurité des données. Les systèmes RAG hébergés localement ou dans l’institution peuvent empêcher les données sensibles des patients de quitter des environnements sécurisés tout en offrant des capacités d’IA de pointe.

Gardez les Radiologues dans la Boucle

Positionnez l’IA comme un outil de soutien à la décision, et non comme un remplacement. Cette approche humain dans la boucle rassure tant les cliniciens que les patients sur le fait que l’IA améliore les soins sans éroder la responsabilité professionnelle.

Développez la Culture de l’IA au sein de l’Équipe

Offrez des sessions de formation et des discussions qui aident les radiologues à comprendre à la fois les capacités et les limitations des rapports générés par l’IA. Une équipe qui sait quand faire confiance et quand remettre en question est bien mieux équipée pour utiliser l’IA en toute sécurité.

Conclusion

La confiance est la base de l’IA en radiologie. La précision à elle seule n’est pas suffisante ; les rapports doivent être transparents, vérifiables et intégrés de manière fluide dans les flux de travail cliniques.

La génération augmentée par récupération, l’explicabilité et des métriques d’évaluation rigoureuses montrent comment l’IA peut passer d’une boîte noire à un partenaire de confiance.

Avec des plateformes comme Medicai intégrant ces principes dans les environnements PACS, les radiologues peuvent adopter l’IA en toute confiance. Nous aidons à obtenir rapidité et efficacité tout en conservant l’expertise humaine au cœur de chaque décision.